Spisu treści:

- Autor John Day day@howwhatproduce.com.

- Public 2024-01-30 11:28.

- Ostatnio zmodyfikowany 2025-06-01 06:10.

Ideą/pchnięciem przy realizacji tego projektu była pomoc osobom, które mają trudności z porozumiewaniem się za pomocą mowy i porozumiewaniem się za pomocą gestów rąk lub popularnie zwanego amerykańskim językiem migowym (ASL). Ten projekt może być krokiem w kierunku zapewnienia tym osobom możliwości pracy z innymi osobami, które nie rozumieją języka migowego, we wspólnym środowisku. Ponadto ten projekt umożliwi im wygłaszanie przemówień publicznych bez korzystania z rzeczywistego ludzkiego tłumacza. Na początku próbowałem tylko wykryć niektóre łatwiejsze gesty, takie jak alfabety A, B, I itp., A także przypisałem pewne gesty do popularnych słów/pozdrowień, takich jak „Witaj”, „Dzień dobry” itp.

Krok 1: Montaż obwodu

Krok 2: Szczegóły projektu

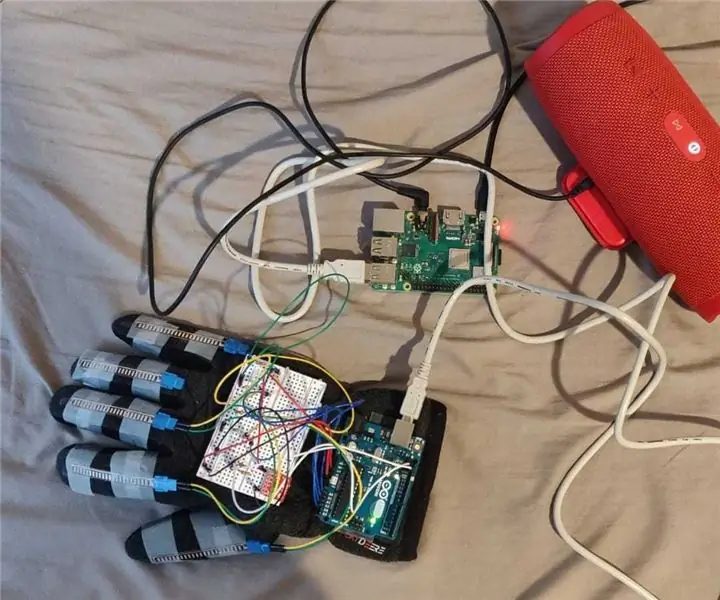

Ten projekt obejmuje rękawice do noszenia z 4 czujnikami zginania wklejonymi/wbudowanymi w rękawicę - po jednym na mały, środkowy, wskazujący i kciuk. Czujnik Flex nie był używany w przypadku palca pierścieniowego ze względu na ograniczenia dostępności pinów wejścia analogowego w Arduino Uno R3 i ogólnie z powodu braku niezależnego ruchu wyświetlanego przez palec w językach migowych. Wykorzystywany jest również akcelerometr MMA8452Q, który przykleja się z tyłu dłoni, aby zmierzyć orientację dłoni. Dane wejściowe z tych czujników są analizowane i wykorzystywane do wykrywania gestu. Po wykryciu gestu odpowiedni znak/wiadomość jest zapisywana w zmiennej. Te znaki i komunikaty łączą się ze sobą, aż do wykonania określonego z góry gestu, wskazującego na dokończenie zdania. Po wykryciu tego specjalnego gestu zapisany ciąg zdań jest wysyłany do Raspberry Pi za pomocą kabla USB przez Arduino. Następnie Raspberry Pi wysyła otrzymany ciąg do usługi Amazon Cloud Service o nazwie Polly, aby przekonwertować zdanie otrzymane w formacie tekstowym na format mowy, a następnie przesyła strumieniowo odebraną mowę do głośnika podłączonego do Raspberry Pi za pomocą kabla AUX.

Ten projekt był tylko dowodem koncepcji, z lepszym sprzętem i planowaniem oraz lepiej skalibrowanym do wykrywania wielu innych gestów i ruchów rąk. Obecnie w tym projekcie zaprogramowana jest tylko ograniczona funkcjonalność, taka jak podstawowe wykrywanie gestów i wyjście tekstu na mowę.

Krok 3: Kod

Krok 4: Kroki

1. Podłącz czujniki flex i akcelerometr MMA8452Q do Arduino zgodnie z dostarczonym schematem obwodu.

2. Zrzuć program Final_Project.ino (znajdujący się w pliku Arduino_code.zip) do Arduino.

3. Podłącz Arduino do Raspberry Pi za pomocą kabla USB. (Kabel typu A/B).

4. Włącz Raspberry Pi, skopiuj plik Raspberry_pi_code.zip do Raspberry Pi i rozpakuj go. Podłącz głośnik do Raspberry Pi.

5. Skopiuj poświadczenia konta AWS, tj. aws_access_key_id, aws_secret_access_key i aws_session_token do pliku ~/.aws/credentials. Ten krok jest wymagany do komunikacji z chmurą AWS i korzystania z usług AWS.

6. Uruchom program seria_test.py znaleziony w wyodrębnionym folderze w kroku 4.

7. Teraz wykonaj gesty, aby ułożyć zdanie, a następnie wykonaj specjalny gest (Trzymaj palce i dłoń prosto i w jednej linii z dłonią skierowaną od siebie, a następnie obróć nadgarstek, obracając go w dół, tak aby teraz twoja dłoń jest skierowany do Ciebie, a czubki palców skierowane w dół w kierunku Twoich stóp).

8. Sprawdzaj terminal w poszukiwaniu przydatnych informacji.

9. I słuchaj przekonwertowanej mowy przesyłanej strumieniowo przez głośnik.

Krok 5: Referencje

1.

2.

3.

4.

Zalecana:

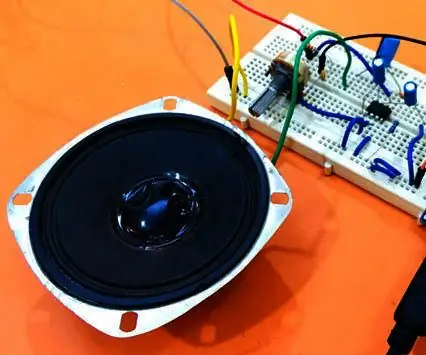

Konwerter tekstu na mowę Arduino za pomocą LM386 - Mówiący projekt Arduino - Biblioteka Talkie Arduino: 5 kroków

Konwerter tekstu na mowę Arduino za pomocą LM386 | Mówiący projekt Arduino | Biblioteka Talkie Arduino: Cześć, w wielu projektach wymagamy, aby arduino mówił coś w rodzaju mówiącego zegara lub podawał niektóre dane, więc te instrukcje przekonwertujemy tekst na mowę za pomocą Arduino

Bubble Talk: Zmień swoją mowę w bąbelki!: 6 kroków (ze zdjęciami)

Bubble Talk: Turn Your Speech Into Bubbles!:”quod, ut dicitur, si est homo bulla, eo magis senex (bo jeśli, jak mówią, człowiek jest bańką, tym bardziej jest starcem)” – Marek Terentius Varro (116 pne - 27 pne), De Re Rustica Bańka mydlana jest efemeryczna. Trwa tylko krótką chwilę i qui

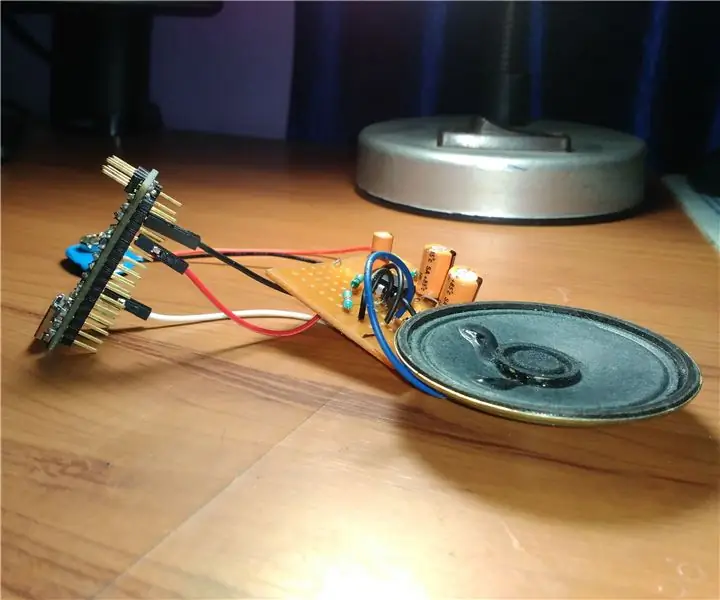

Arduino TTS (tekst na mowę): 3 kroki (ze zdjęciami)

Arduino TTS (Text to Speech): Cześć, dzisiaj w tym samouczku nauczę Cię, jak sprawić, by Twój Arduino mówił bez żadnego modułu zewnętrznego. Tutaj możemy to wykorzystać w wielu projektach, takich jak mówiący termometr, Roboty i wiele innych. Więc bez marnowania czasu zacznijmy ten projekt

Rękawica kreatora: rękawica kontrolera Arduino: 4 kroki (ze zdjęciami)

Wizard Glove: rękawica kontrolera Arduino: The Wizard Glove. W moim projekcie stworzyłem rękawicę, której możesz użyć do grania w swoje ulubione gry związane z magią w fajny i wciągający sposób, używając tylko kilku podstawowych zasobów arduino i arduino. możesz grać w takie gry, jak starsze zwoje lub

Tekst na mowę Bullhorn: 4 kroki

Tekst na mowę Bullhorn: to najprostszy sposób, jaki znalazłem, aby stworzyć skuteczny bullhorn z tekstem na mowę dla głuchego przyjaciela. Bo wiesz, to sprawia, że są jeszcze bardziej radośni. Nie jest to szczególnie satysfakcjonujący ani edukacyjny projekt budowy i wymaga zakupu