Spisu treści:

- Autor John Day day@howwhatproduce.com.

- Public 2024-01-30 11:29.

- Ostatnio zmodyfikowany 2025-01-23 15:03.

Wykryj ruch i zniszcz cel

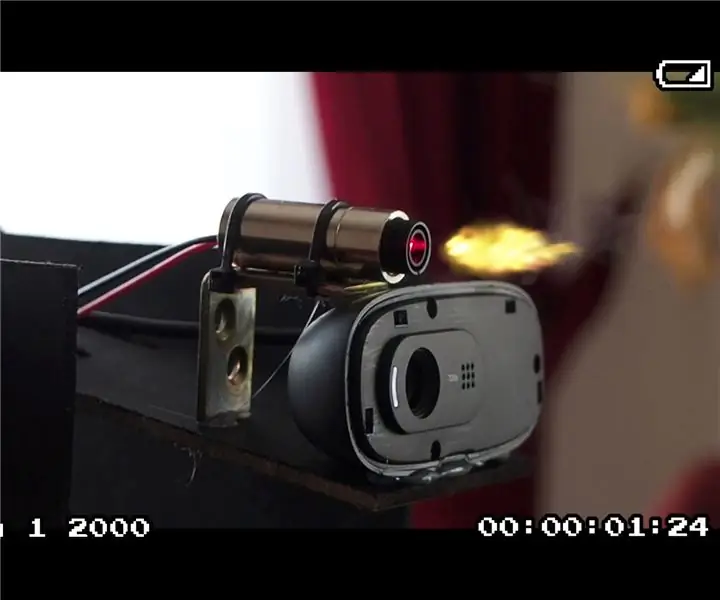

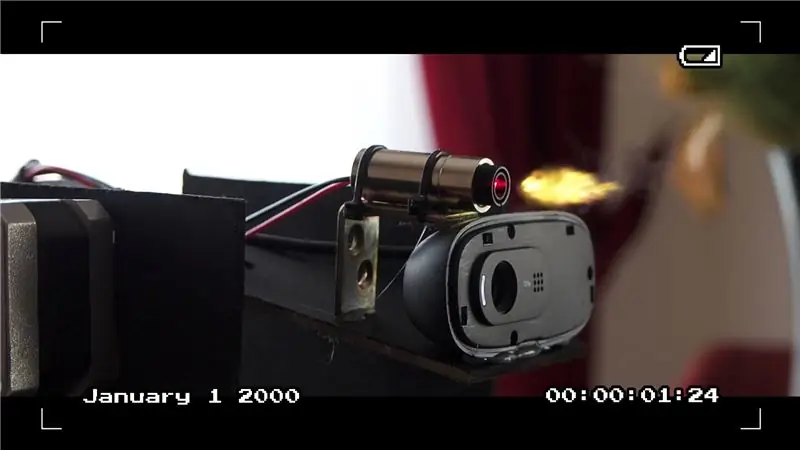

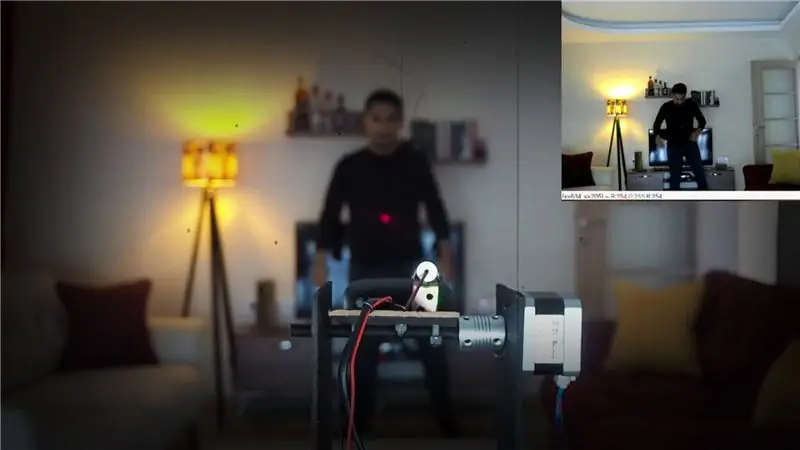

W tym filmie pokazuję, jak zbudować własny projekt śledzenia ruchu za pomocą Raspberry Pi 3. Projekt jest autonomiczny, więc porusza się i strzela z pistoletu, gdy wykryje ruch. Użyłem modułu laserowego do tego projektu, ale możesz łatwo zmienić tę kompilację, aby zamiast tego używała Nerf.

Ten projekt pozwala wykryć i śledzić osobę za pomocą OpenCV, a następnie uruchomić urządzenie (takie jak laser lub pistolet).

Krok 1: Samouczek wideo - krok po kroku

Komponenty sprzętowe

Do sprzętu używanego w projekcie można dotrzeć z poniższych linków:

Raspberry Pi 3 Model B+

Adapter Raspberry Pi

Silnik krokowy kapelusz

Adapter 12V do silnika HAT

Moduł przekaźnikowy

Wentylator Pi 5V

Oficjalna kamera Pi V2 lub kamera internetowa Kamera PC

Moduł laserowy 5 V lub pistolet Nerf

Koło krokowe

Spoiwo

Śruby M3

Wspornik w kształcie litery L

Sprzęgło wału

Szyna liniowa

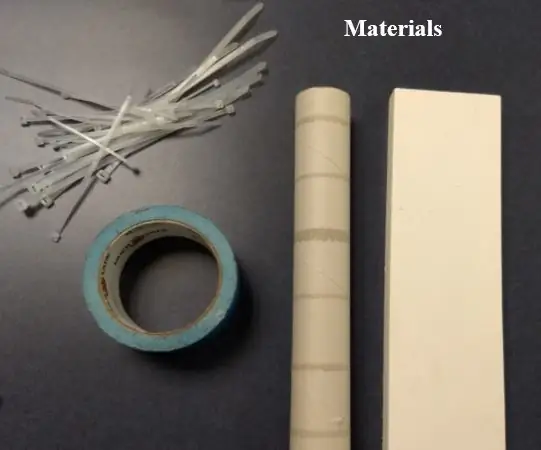

Opaska kablowa

Arkusz MDF

Farba w sprayu

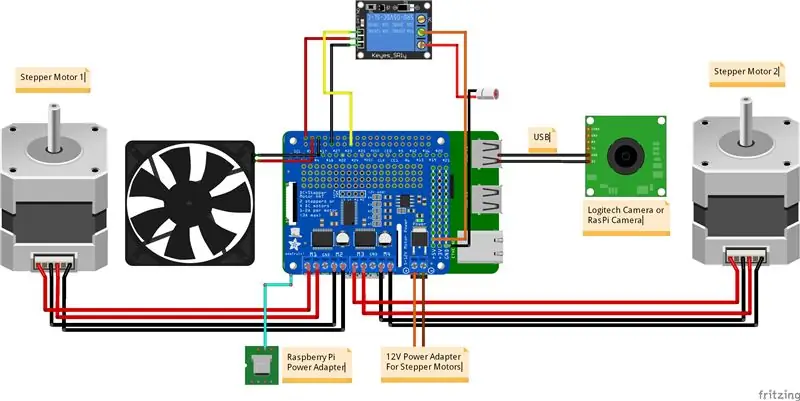

Krok 2: Schemat obwodu

Możesz uzupełnić swoje połączenia zgodnie z powyższym obwodem. Pin GPIO22 służy do sterowania przekaźnikami w ramach kodu.

PRZEKAŹNIK_PIN = 22

Krok 3: Instrukcja instalacji - OpenCV i Pip

1. Upewnij się, że pip jest zainstalowany

sudo apt-get zainstaluj python pip

www.pyimagesearch.com/2018/09/19/pip-install-opencv/

2. Zainstaluj OpenCV 3. Wykonaj wszystkie kroki dla instrukcji Pythona 3

www.pyimagesearch.com/2016/04/18/install-guide-raspberry-pi-3-raspbian-jessie-opencv-3/

3. Skonfiguruj I2C na swoim Raspberry Pi

learn.adafruit.com/adafruits-raspberry-pi-lesson-4-gpio-setup/configuring-i2c

4. Zainstaluj bibliotekę HAT silnika krokowego Adafruit

sudo pip zainstaluj git+https://github.com/adafruit/Adafruit-Motor-HAT-Python-Library

5. Adres I2C

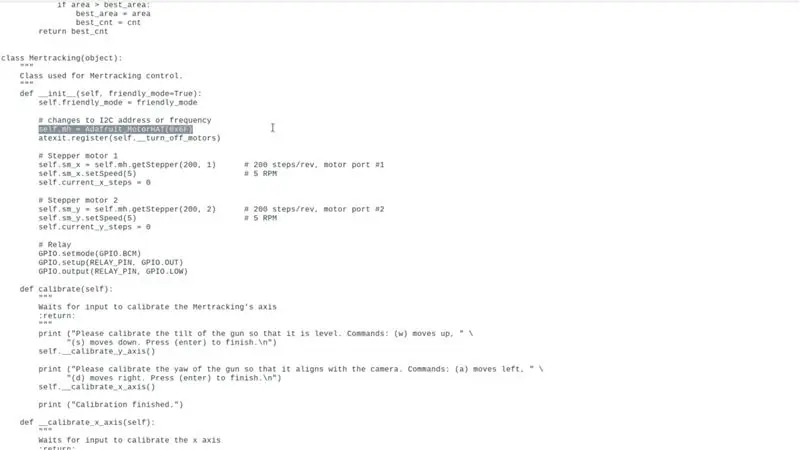

Jeśli używasz Raspberry Pi Stepper Motor Expansion Board innego niż Adafruit Stepper Motor HAT (tak jak na filmie), zaktualizuj adres I2C lub wartość częstotliwości w następujący sposób. (Ten adres jest zgodny tylko z płytą w filmie, domyślna wartość jest pusta dla kapelusza silnika krokowego Adafruit Stepper HAT)

self.mh = Adafruit_MotorHAT()

do

self.mh = Adafruit_MotorHAT(0x6F)

w kodzie źródłowym (mertracking.py)

więcej szczegółów:

6. Upewnij się, że tworzysz swoje wirtualne środowisko z dodatkową flagą

mkvirtualenv cv --system-site-packages -p python3

7. Otwórz Terminal i aktywuj swoje środowisko wirtualne

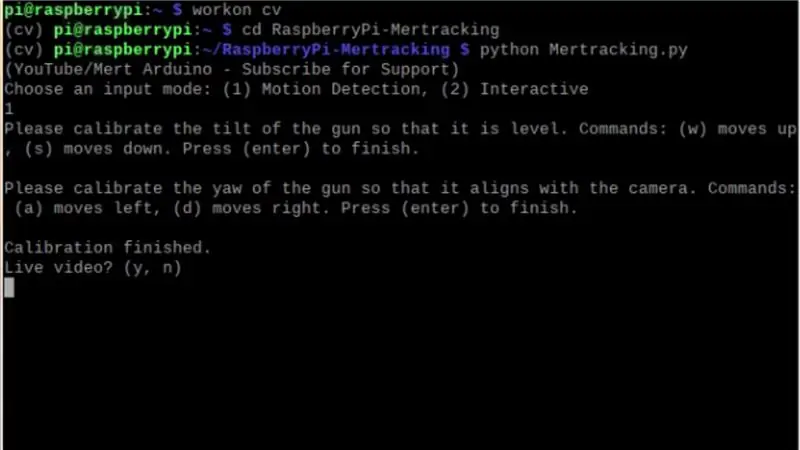

praca na cv

8. Sklonuj to repozytorium

git klon git@github.com:MertArduino/RaspberryPi-Mertracking.git

9. Przejdź do katalogu

cd RaspberryPi-Mertracking

10. Zainstaluj zależności w swoim środowisku wirtualnym

pip zainstaluj imutils RPi. GPIO

11. Uruchom kod

python mertracking.py

Krok 4: Ustawianie parametrów

mertracking.py ma kilka parametrów, które możesz ustawić:

MOTOR_X_REVERSED = Fałsz

MOTOR_Y_REVERSED = Fałsz MAX_STEPS_X = 20 MAX_STEPS_Y = 10 RELAY_PIN = 22

Adres lub częstotliwość I2C

self.mh = Adafruit_MotorHAT(0x6f)

Prędkość silników krokowych

self.sm_x.setSpeed(5)

self.sm_y.setSpeed(5)

Kroki/obrót silników krokowych

self.sm_x = self.mh.getStepper(200, 1)

self.sm_y = self.mh.getStepper(200, 1)

Czas opóźnienia dla wyzwalania przekaźnika

czas.sen(1)

Możesz zmienić typ kroku za pomocą następujących poleceń

Adafruit_MotorHAT. MICROSTEP

MICROSTEP - POJEDYNCZY - PODWÓJNY - PRZEKŁADANY

Krok 5: Kod źródłowy

Pobierz kod z GitHub -

Sklonuj to repozytorium:

git klon git@github.com:MertArduino/RaspberryPi-Mertracking.git

Zalecana:

Nocne światło wykrywające ruch i ciemność – bez mikro: 7 kroków (ze zdjęciami)

Night Light Motion & Darkness Sensing - No Micro: Ta instrukcja ma na celu zapobieganie ukłuciu palca podczas chodzenia po ciemnym pokoju. Można powiedzieć, że to dla własnego bezpieczeństwa, jeśli wstaniesz w nocy i spróbujesz bezpiecznie dotrzeć do drzwi. Oczywiście możesz użyć lampki nocnej lub głównego li

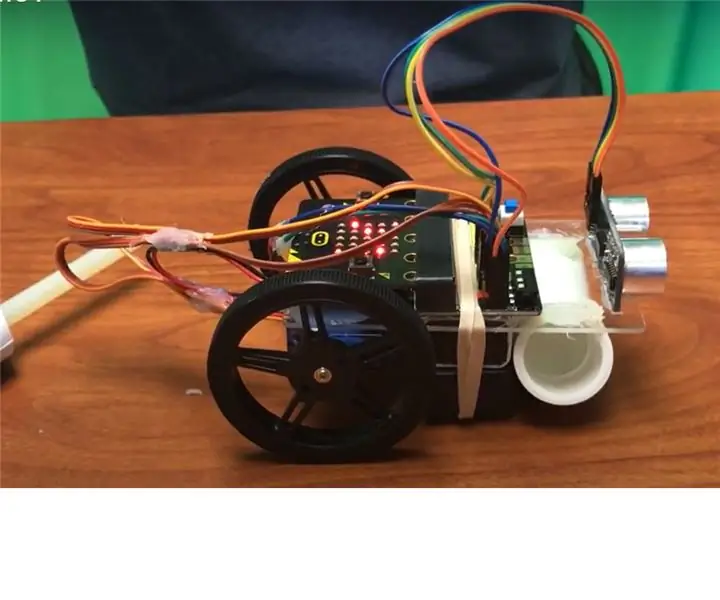

Podstawowy ruch Waltera mikrobota: 26 kroków

Walter the Microbot Bot Basic Move: Będziemy programować Walter the Microbot:Bot

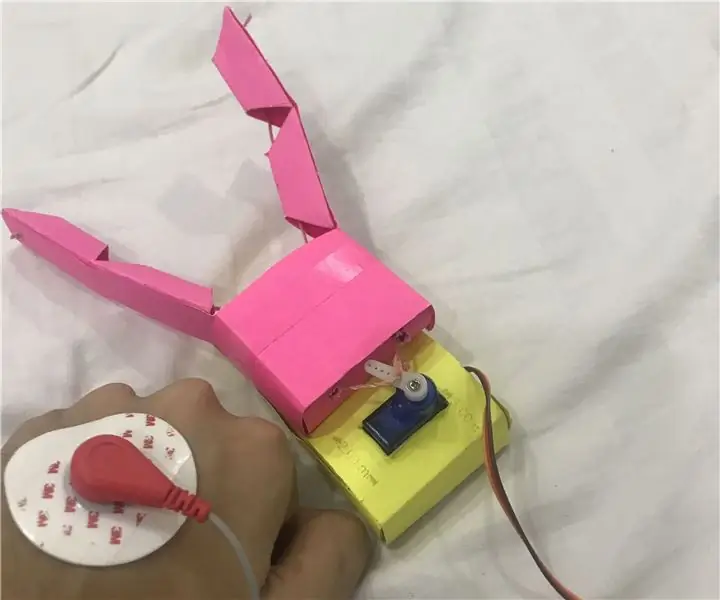

Interfejs człowiek-komputer: obsługa chwytaka (wykonanego przez Kirigami) poprzez ruch nadgarstka za pomocą EMG.: 7 kroków

Interfejs człowiek-komputer: Funkcja chwytaka (wykonanego przez Kirigami) za pomocą ruchu nadgarstka za pomocą EMG.: Więc to była moja pierwsza próba z interfejsem człowiek-komputer. Uchwyciłem sygnały aktywacji mięśni mojego ruchu nadgarstka za pomocą czujnika EMG, przetworzyłem je przez pytona i arduino i uruchomiono chwytak oparty na origami

Laser Arduino wykrywający ruch: 5 kroków

Laser Arduino wykrywający ruch: UWAGA: Ten projekt został zaprojektowany w taki sposób, aby wszystkie części mogły być ponownie wykorzystane w przyszłych projektach. W rezultacie produkt końcowy jest mniej stabilny niż w przypadku użycia bardziej trwałych materiałów, takich jak klej, lutowanie itp. Ostrzeżenie: nie

Sterowanie pokojowe za pomocą ESP8266 - Temperatura, ruch, zasłony i oświetlenie: 8 kroków

Sterowanie pokojowe za pomocą ESP8266 | Temperatura, ruch, zasłony i oświetlenie: Ten projekt opiera się na systemie opartym na module NodeMCU ESP8266, który pozwala kontrolować jasność taśmy LED i zasłony w pomieszczeniu, a także jest w stanie przesyłać dane o zdarzeniach ruchu w pomieszczeniu a temperatura do chmury w