Spisu treści:

- Autor John Day day@howwhatproduce.com.

- Public 2024-01-30 11:28.

- Ostatnio zmodyfikowany 2025-01-23 15:02.

By buzquirkhttps://buzquirk.comObserwuj Więcej autora:

Cześć wszystkim, W tym Instruktażowym przedstawię proces tworzenia modeli 3D przy użyciu zdjęć cyfrowych. Proces ten nazywa się fotogrametrią, znaną również jako modelowanie oparte na obrazie (IBM). W szczególności ten rodzaj procesu służy do odtwarzania dowolnego obiektu lub przestrzeni w trzech wymiarach. Od artefaktów i dzieł sztuki po przestrzenie, takie jak formy geologiczne i ruiny, pokażę, jak stworzyć animację portretu modelu 3D i zademonstrować przepływ pracy potrzebny do realizacji tego typu kreatywnego przedsięwzięcia.

Krok 1: Oprogramowanie

Najpierw zdobądź oprogramowanie potrzebne do tworzenia modeli 3D z obrazów. To zawiera:

Wizualne SFM -

Następnie należy zrekonstruować model 3D. To zawiera:

Meshlab -

Na koniec ostatnie ulepszenia przy użyciu innego oprogramowania, takiego jak:

Maya (wersja studencka lub bezpłatna wersja próbna), Blender lub dowolny program do modelowania 3D

Krok 2: Obrazy do VisualSFM

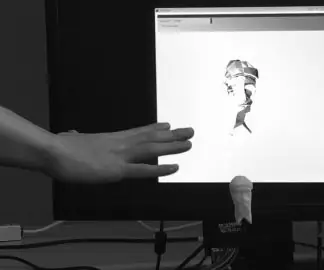

Teraz, gdy masz już swoje oprogramowanie, wyjdź i uchwyć surowe nagrania dowolnego obiektu, przestrzeni lub środowiska. Istnieją dwa sposoby przechwytywania materiału do modeli 3D:

Jednym ze sposobów jest drobiazgowe obracanie się wokół obiektu lub przestrzeni w sposób zbieżny z każdym krokiem i robienie zdjęcia.

Drugim sposobem jest nagranie wideo i obracanie się wokół obiektu lub przestrzeni. Następnie przejdź do Adobe Media Encoder i podziel wideo na pojedyncze klatki. Oczywiście, im więcej klatek nagrywa kamera, tym więcej materiału można uzyskać, a tym samym uzyskać więcej szczegółów w przechwytywaniu 3D.

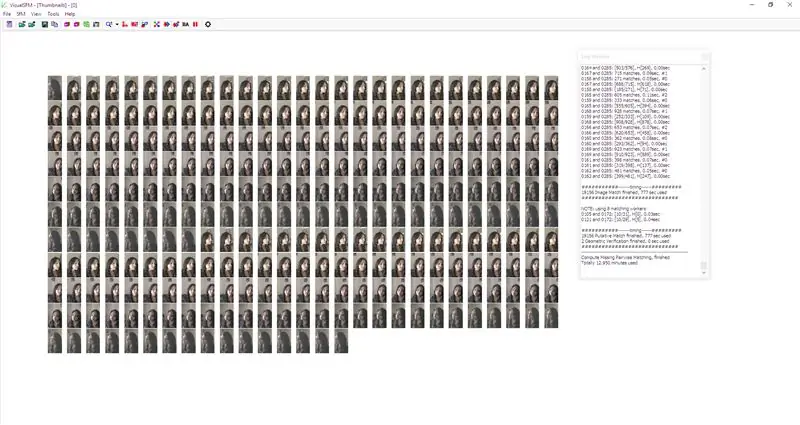

W VisualSFM:

1. Plik - Open+ Multi Images (Tutaj bierzesz swoje klatki lub zdjęcia i importujesz je do VisualSFM)

2. Teraz, gdy masz już wszystkie swoje obrazy, przejdź dalej i kliknij przycisk Oblicz brakujące dopasowania. To przycisk, który ma 4 strzałki skierowane na zewnątrz. Ten proces może zająć dużo czasu w zależności od liczby przesłanych zdjęć. Powodem, dla którego trwa to tak długo, jest to, że oprogramowanie porównuje każdy obraz z innymi przesłanymi obrazami, porównując podobne punkty i aspekty, aby rozpocząć proces odtwarzania modelu 3D, więc prosimy o cierpliwość.

3. Po zakończeniu tego procesu kliknij przycisk Compute 3D Reconstruction. Jest to przycisk, który wygląda jak przycisk szybkiego przewijania do przodu, ale bez plusa (znajduje się tuż obok przycisku Compute Missing Matches). To tutaj VisualSFM robi zdjęcia z podobnymi aspektami między sobą i zaczyna tworzyć model 3D przestrzeni, obiektu lub osoby. VisualSFM bierze pod uwagę surowe dane obrazu, a także odległość i głębokość obiektów biorących udział w każdym zdjęciu, dzięki czemu jest w stanie odtworzyć dany obiekt jako model 3D. Powodem, dla którego nazywa się to VisualSFM (Structure From Motion) jest to, że proces SfM porównuje dwuwymiarowe sekwencje obrazów i szacuje trójwymiarowe struktury (modele 3D).

4. Po wykonaniu tej czynności idź dalej i kliknij CMVS, aby uzyskać gęstą rekonstrukcję. To zakończy model 3D i chcesz zapisać plik.cmvs i plik.nvm oraz plik.ply. Będziesz potrzebował pliku.nvm dla Meshlab i będziesz potrzebował pliku.ply, aby uzyskać siatkę 3D twojego obiektu lub siatki, co również stanie się w Meshlab.

Zalecana:

(Bardzo proste) Modelowanie choroby (przy użyciu Scratch): 5 kroków

(Bardzo proste) Modelowanie choroby (przy użyciu Scratch): Dzisiaj będziemy symulować wybuch choroby, przy czym będzie to jakakolwiek choroba, niekoniecznie COVID-19. Ta symulacja została zainspirowana filmem 3blue1brown, do którego podam link. Ponieważ jest to metoda przeciągania i upuszczania, nie możemy zrobić tyle, ile możemy z JS lub Pyt

Modelowanie sygnału EKG w LTspice: 7 kroków

Modelowanie sygnału EKG w LTspice: EKG jest bardzo powszechną metodą pomiaru sygnałów elektrycznych występujących w sercu. Ogólną ideą tej procedury jest wykrycie problemów z sercem, takich jak arytmie, choroba wieńcowa lub zawał serca. Może to być konieczne, jeśli pacjent jest

Modelowanie i renderowanie deskorolek w Fusion 360: 7 kroków

Koncepcja modelowania i renderowania Deskorolki w Fusion 360: Odkryłem, że chociaż budowanie fizycznej maszyny, takiej jak deskorolka, jest zabawne i satysfakcjonujące, czasami po prostu chcemy usiąść w jednym miejscu i modelować niesamowicie wyglądające wyniki… bez żadnych narzędzia, materiały lub cokolwiek innego! Właśnie to

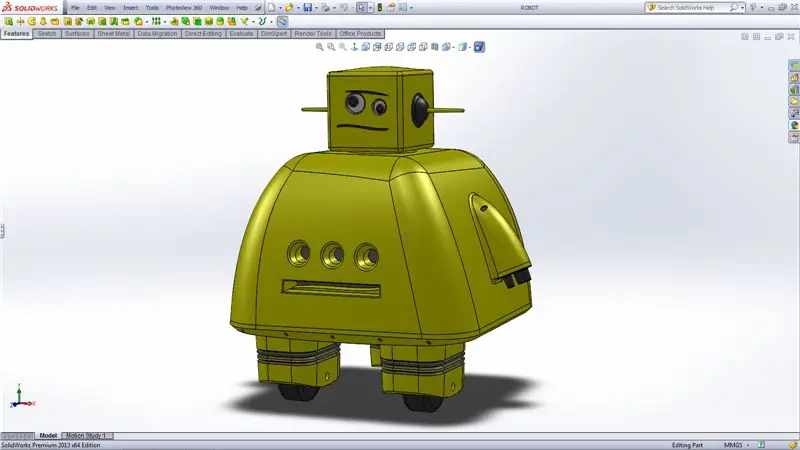

Modelowanie 3D robota Instructables: 6 kroków

Modelowanie 3D robota Instructables: Model jest przeznaczony do użytku jako zabawka lub dekoracja podczas drukowania 3D. jego rozmiar to ok. 8x8x6 cm. Obrazy są dość oczywiste, a funkcje solidworks wymienione w lewym menu krok po kroku w miarę postępu procesu. Pliki STL dla

Modelowanie Fidget Spinner w CAD: 6 kroków

Modelowanie Fidget Spinner w CAD: Tak naprawdę nie myślałem zbyt wiele o posiadaniu Fidget Spinner, dopóki mój młodszy brat nie kupił mi go w prezencie. I kocham to! Teraz mam kilka różnych i prawie zawsze mam przy sobie jedną. Osobiście wierzę, że zabawki fidget MOGĄ być korzystne